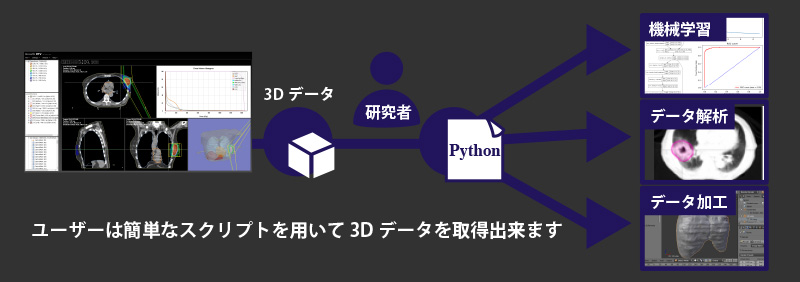

研究者・開発者向けPython連携プラットフォーム

従来の問題点

深層学習にとって、DICOM-RTデータはCTと臓器輪郭がセットとなっている貴重な資源でありますが、これまで、DICOM-RTデータを簡便に解析・再構成・データ抽出を可能とするツールはなかったため、研究がスムーズに実施できない、解析を外注するに大きなコストが発生するなどの問題があり、効率的なデータ活用が行なえませんでした。

APIによるシームレスな抽出

Growth RTVのPython連携プラットフォームを利用すれば、ユーザーはDICOMの扱い方を知らなくても、簡単なPythonスクリプトで3D画像データを取得し、機械学習・データ解析・データ加工等を行えます。また、本プラットフォーム介し、CTやDICOM-RTデータへ新たな臓器領域を追加定義できるため、研究実施チーム(大学・企業)と評価チーム(医療機関)は本プラットフォームを介してスムーズな研究実施と研究成果の評価が行なえます。

活用例

・臓器自動領域抽出、腫瘍自動認識向け深層学習用データの大量生成

・臓器領域のマージ(足し算)や分離(引き算)後に新たな臓器として追加定義

・研究実施機関と評価機関の分業促進

自動抽出の研究対象臓器または腫瘍に対し

AI開発成果例

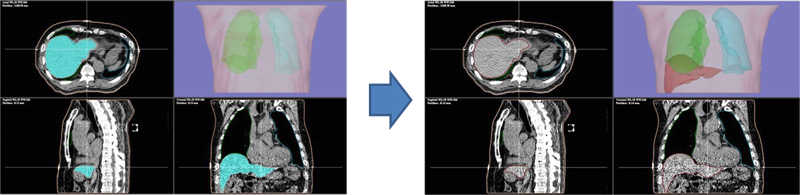

AIによる臓器の3D領域自動抽出

Growth RTV製品で搭載されている臓器抽出AIの開発にも本プラットフォームを利用しています

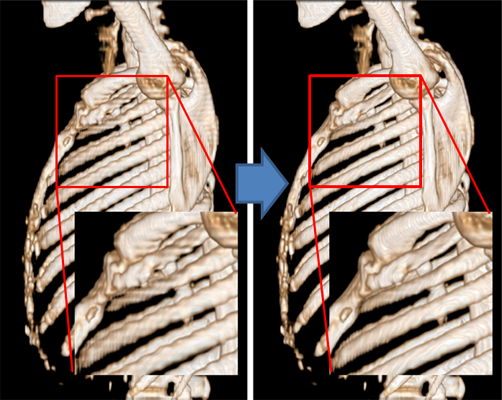

AIによる3D-CT超解像

疎な3D-CTから密な3D-CTへの補間を学習することで、画像劣化なく3D像を平滑化、高解像化するAIを開発しました。従来の線形補間よりも正しく画素値を予測可能です。

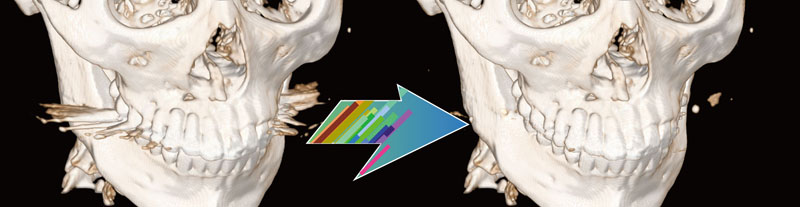

AIにCT金属アーチファクト低減(MAR)

敵対的生成ネットワークを利用して、3D-CT内の金属アーチファクト低減AIの開発に成功しました。現在試験的にクラウドサービスを提供中です。

AIによるMAR技術詳細 >>

Pythonスクリプト例

CTの3Dデータ取得例

#本プラットフォームより提供されたクラスpyGRTVを利用してデータアクセスを行います

grtv = pyGRTV() # インスタンス生成

grtv.readRTDir(“c:/testdata/”) # DICOM-RT読み込み

ret, img_short = grtv.readGRTVRaw(grtv.GRTV_DATA_TYPE_IMAGE) # 3Dデータ取得

grtv.writeRaw(“c:/testdata_ct.raw”, img_short , dataType=np.int16) # ファイル保存

関心領域の3Dデータ取得例

grtv = pyGRTV() # インスタンス生成

grtv.readRTDir(“c:/testdata/”) # DICOM-RT読み込み

ret, roi_uint8 = grtv.readGRTVRaw(grtv.GRTV_DATA_TYPE_ROI, dataID=0) # 0番目のROIを取得

grtv.writeRaw(“c:/testdata_roi_0.raw“, roi_uint8, dataType=np.uint8) # ファイル保存

関心領域の3Dメッシュ(PLY形式 or STL形式)の一括書き出し例

grtv = pyGRTV() # インスタンス生成

grtv.readRTDir(“c:/testdata/”) # DICOM-RT読み込み

roiList = []

ret = grtv.getROIList(roiList) # 定義済みROIリスト取得

#ROIごとにPLY形式で書き出し

for roi in roiList:

meshPath = “c:/mesh/%s.ply” % (roi[“roi_name”])

ret = grtv.exportROIMesh(dataID=int(roi[“roi_index”]),

meshPath=meshPath, meshType=grtv.GRTV_MESH_TYPE_PLY)

Python API リファレンス

Return to Top ▲

Return to Top ▲